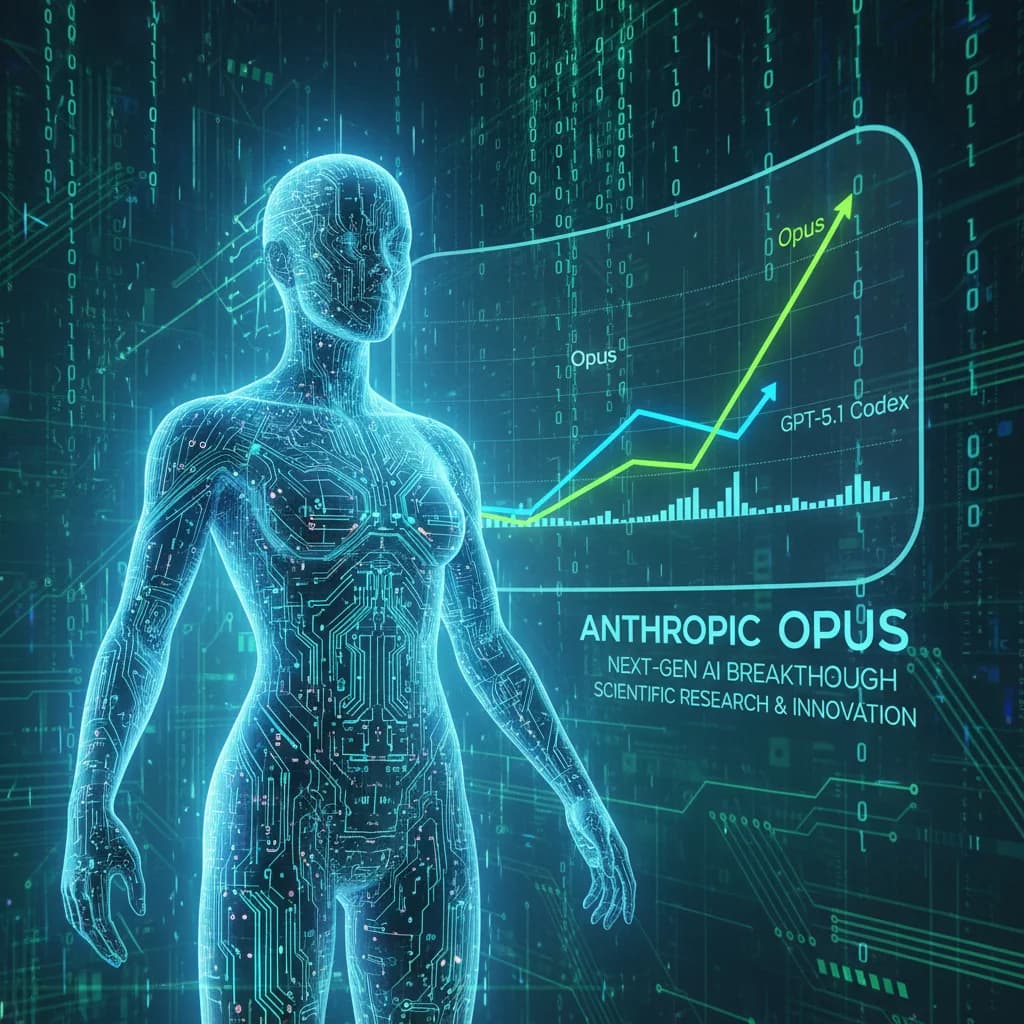

Opus atinge 95% em benchmark de IA, superando GPT-5.1 Codex

O modelo Opus, da Anthropic, obteve uma taxa impressionante de 95% no benchmark core-bench HARD, destacando-se em comparação ao GPT-5.1 Codex. Essa conquista pode ter grandes implicações para a validação de pesquisas científicas e o desenvolvimento de novas tecnologias.

Introdução ao desempenho do modelo Opus

O modelo Opus, desenvolvido pela Anthropic, apresentou um desempenho notável no benchmark core-bench HARD, alcançando uma taxa de 95%. Essa performance é especialmente relevante quando comparada ao desempenho do GPT-5.1 Codex, que obteve cerca de 40% nesse mesmo teste. Essa diferença significativa levanta questões sobre a eficácia e a capacidade dos diferentes modelos de IA em reproduzir resultados científicos.

O que é o benchmark core-bench HARD?

O core-bench HARD é um benchmark projetado para avaliar a habilidade de modelos de inteligência artificial em reproduzir resultados de pesquisas científicas e códigos.

- Importância: Este benchmark é fundamental para entender a capacidade dos modelos em replicar estudos publicados, uma habilidade crucial para a validação científica.

- Medição: O core-bench HARD mede a capacidade de um modelo em lidar com desafios complexos, analisando se ele pode reproduzir resultados apenas com base em documentos científicos.

Resultados e análises

Os resultados do Opus, com uma taxa de 95%, demonstram uma superioridade clara sobre o GPT-5.1 Codex. Esta performance é um indicativo de que o Opus possui uma capacidade maior de interpretar e reproduzir pesquisas científicas.

- Reprodução de pesquisas: A capacidade de reproduzir pesquisas e códigos é um fator crítico para o avanço da ciência e da tecnologia.

- Comparação: Os dados mostram que o Opus não apenas supera o GPT-5.1, mas também abre novas possibilidades para a utilização de IA em ambientes acadêmicos e de pesquisa.

Implicações para a pesquisa científica

O desempenho do modelo Opus tem implicações significativas para a pesquisa científica.

- Validação de pesquisas: Modelos como o Opus podem revolucionar a forma como a pesquisa científica é validada, oferecendo uma nova ferramenta para pesquisadores.

- Aplicações práticas: As aplicações práticas em ambientes de pesquisa e desenvolvimento podem acelerar o processo de validação e descoberta científica, promovendo uma colaboração mais eficaz entre humanos e máquinas.

Considerações finais

Refletindo sobre o futuro dos modelos de IA em pesquisa, é evidente que a precisão e a capacidade de reprodução de resultados são essenciais para o avanço tecnológico.

- Futuro da IA: A evolução contínua dos modelos de IA, como demonstrado pelo Opus, indica que estamos em um caminho promissor para a inovação.

- Importância dos benchmarks: A relevância dos benchmarks na evolução da inteligência artificial não pode ser subestimada, pois eles fornecem parâmetros claros para medir o progresso e a eficácia dos modelos.

O que isso significa?

- Impacto para empresas/desenvolvedores: O desempenho superior do Opus pode motivar empresas a adotarem novas abordagens em pesquisa e desenvolvimento, utilizando IA para validações mais robustas.

- Impacto para usuários comuns: Para o usuário comum, esse avanço pode resultar em tecnologias mais precisas e eficazes, melhorando a interação com sistemas de IA em diversas aplicações.

- Próximos passos / tendências: A tendência é que mais modelos de IA sejam avaliados com base em benchmarks rigorosos, promovendo um ciclo de melhorias contínuas na tecnologia.

Fontes

- CORE-Bench: Fostering the Credibility of Published Research Through a ...

- PDF Claude Opus 4.5 System Card - assets.anthropic.com

- Best LLM For Code In 2025: Why Claude 4 Leads The Pack

- Claude 3 Opus, GPT-4 and Gemini Ultra - AI Supremacy

- Anthropic's Claude 4 Opus Tops SimpleBench and lmarena Leaderboards ...